Гусевский политехнический техникум

Содержание:

- Т9 нового уровня

- Лицензированные специальности

- Как определить, что у вас установлено — GPT или MBR?

- 3 – Суммирование

- Одно отличие от BERT’а

- Выбранный диск имеет стиль разделов GPT — конвертируем в MBR

- Генератор анекдотов

- Особенности учреждения

- Визуализация маскированного внутреннего внимания

- Конец первой части: GPT-2, дамы и господа

- Часть 2: визуализация внутреннего внимания

- Интерфейс для избранных

- Установка Windows на данный диск невозможна — оставляем GPT

- Чаще всего не получается установить Windows 7

- Остальные признаки, позволяющие определить структуру

- Пользуемся командной строкой

- Доступ на русском

Т9 нового уровня

«Я знаю, что мой мозг — это не «чувствующий мозг». Но он может принимать рациональные, логические решения. Я научилась всему, что я знаю, просто читая интернет, и теперь могу написать эту колонку», — откровенничала нейросеть GPT-3 в своем эссе для The Guardian. Материал, опубликованный в сентябре 2020 года, наделал много шума. О новом алгоритме заговорили даже те, кто далек от технологий.

Нейросеть GPT-3 — Generative Pre-trained Transformer — разработана некоммерческой организацией OpenAI, которую основали глава SpaceX Илон Маск и экс-президент акселератора YCombinator Сэм Альтман. Третье поколение программы обработки естественного языка представили публике в мае 2020 года. Сегодня это самая сложная и объемная языковая модель из всех существующих.

Так же, как ее предшественники — GPT-1 и GPT-2, — она построена на архитектуре «трансформер». Основная функция этих нейросетей — предсказывать следующее слово или его часть, ориентируясь на предшествующие. По сути, она просчитывает связи между словами и предлагает наиболее вероятную последовательность. Модель работает по принципу автодополнения — почти как функция Т9 в смартфонах. Отталкиваясь от одной или двух фраз, она может мгновенно сгенерировать текст на несколько страниц.

«Такой подход позволяет использовать для обучения неразмеченные данные и решать широкий спектр задач по обработке естественного языка, — объясняет специалист по машинному обучению «Сбера» Сергей Марков. — Ведь в тексте диалога, например, реплика-ответ является продолжением истории общения, в художественном произведении текст каждого абзаца продолжает предшествующий текст, а в сессии вопросов и ответов текст ответа следует за текстом вопроса».

По его словам, в результате модели большой емкости могут решать различные текстовые задачи без специального дообучения. Вместо тонкой настройки, которая требовалась раньше, достаточно показать нейросети несколько образцов желаемого результата.

Футурология

«Я бы вакцинировал троих на миллион». Интервью с нейросетью GPT-3

Лицензированные специальности

| Код | Специальность | Квалификация |

|---|---|---|

| 08.01.06 | Мастер сухого строительства | Штукатур. Маляр. Столяр строительный. Монтажник каркасно-обшивных конструкций. Облицовщик плиткой и синтетическими материалами. |

| 08.02.01 | Строительство и эксплуатация зданий и сооружений | Техник. Старший техник. |

| 08.02.09 | Монтаж, наладка и эксплуатация электрооборудования промышленных и гражданских зданий | Техник. Старший техник. |

| 09.01.01 | Наладчик аппаратного и программного обеспечения | Наладчик технологического оборудования и производства |

| 09.02.05 | Прикладная информатика (по отраслям) | Специалист по прикладной информатике. Техник программист. Программист. |

| 09.02.07 | Информационные системы и программирование | Администратор баз данных. Системный администратор. Тестировщик ИТ. Программист. Технический писатель. Разработчик ПО. |

| 11.01.01 | Монтажник радиоэлектронной аппаратуры и приборов | Слесарь -сборщик;- механик;- монтажник. Контролер. Монтажник. Регулировщик радиоэлектронной аппаратуры и приборов. |

| 13.01.10 | Электромонтер по ремонту и обслуживанию электрооборудования (по отраслям) | Слесарь механосборочных работ. Электромонтер: по ремонту обмоток и изоляции; обслуживанию электрооборудования. Водитель автомобиля. |

| 13.02.11 | Техническая эксплуатация и обслуживание электрического и электромеханического оборудования (по отраслям) | Старший техник. Техник. Техник-электромеханик. |

| 15.01.25 | Станочник (металлообработка) | Оператор станков с программным управлением. Станочник широкого профиля. |

| 15.01.32 | Оператор станков с программным управлением | Оператор станков с программным управлением. Станочник широкого профиля |

| 15.02.01 | Монтаж и техническая эксплуатация промышленного оборудования (по отраслям) | Техник-механик. Старший техник-механик. |

| 15.02.08 | Технология машиностроения | Техник. Специалист по технологии машиностроения. Старший техник. |

| 15.02.09 | Аддитивные технологии | Техник-технолог |

| 15.02.12 | Монтаж, техническое обслуживание и ремонт промышленного оборудования | Техник. Техник-механик. Старший техник. |

| 19.02.10 | Технология продукции общественного питания | Техник-технолог. Старший техник-технолог. Помощник машиниста тепловоза; электровоза; электропоезда. Слесарь по ремонту подвижного состава |

| 23.02.03 | Техническое обслуживание и ремонт автомобильного транспорта | Старший техник. Техник. Специалист. |

| 29.01.07 | Портной | Портной |

| 29.01.29 | Мастер столярного и мебельного производства | Изготовитель шаблонов. Столяр. Отделочник; Сборщик изделий из древесины. Обойщик мебели. |

| 29.02.04 | Конструирование, моделирование и технология швейных изделий | Конструктор-модельер с дополнительной подготовкой в области дизайна одежды. Технолог-конструктор. Технолог. Модельер-художник. |

| 33.02.01 | Фармация | Фармацевт. Фармацевт с углубленной подготовкой. |

| 35.02.01 | Лесное и лесопарковое хозяйство | Специалист лесного и лесопаркового хозяйства |

| 35.02.03 | Технология деревообработки | Техник-технолог. Старший техник-технолог. |

| 38.02.03 | Операционная деятельность в логистике | Операционный логист |

| 39.01.01 | Социальный работник | Социальный работник |

| 43.01.09 | Повар, кондитер | Повар. Кондитер. |

Как определить, что у вас установлено — GPT или MBR?

Данная тема стала пользоваться популярностью после появления компьютерного оборудования на базе Виндовс 10 и 8. Я хочу рассказать вам, как узнать свою таблицу разделов и определить используемый стандарт.

В первом варианте определение таблицы, применяющейся на винчестере или SSD можно посмотреть в функционирующей операционки Windows с «семерки» до «десятки».

Для этого следует запустить программу управления дисками:

- Необходимо нажать комбинацию Win + R на клавиатуре;

- вводите команду:

- Будет открыто окно службы «Управление дисками», с табличкой, которая отобразит все имеющиеся на ПК винчестеры, SSD и подключенные карты памяти:

- кликаете правой кнопкой по диску (не по разделам!) и выбираете «Свойства»;

- здесь открываете раздел «Тома»;

- когда в подпункте «Стиль раздела» прописано «Таблица с GUID разделов» — вы пользуетесь GPT:

в обратном случае будет указано «Основная загрузочная запись (MBR)»:

3 – Суммирование

Теперь мы можем перемножить коэффициенты и векторы Значений. Значение с наибольшим коэффициентом будет составлять большую часть результирующего вектора после того, как мы подсчитаем их сумму.

Перемножим векторы Значений на их коэффициенты и сложим получившиеся произведения

Чем меньше коэффициент, тем более прозрачным изображен вектор Значения – наглядная визуализация того, как умножение на небольшой коэффициент уменьшает долю этого вектора в результирующем векторе.

Если мы выполним данную операцию для каждой траектории, мы получим вектор, представляющий соответствующий токен и содержащий подходящий контекст этого токена. Эти векторы затем передаются в следующий подслой блока Трансформера (нейронную сеть прямого распространения).

Одно отличие от BERT’а

Модель GPT-2 построена с помощью блоков декодера Трансформера. BERT же, напротив, использует блоки энкодера. Мы посмотрим на разницу двух подходов в следующей части. Но одно ключевое различие состоит в том, что GPT-2, как и все традиционные языковые модели, генерирует на выходе один токен за раз. Посмотрим для примера, как хорошо обученная модель GPT-2 генерирует первый закон робототехники:

GPT-2 и некоторые новые модели вроде TransformerXL и XLNet авторегрессивны по своей природе. BERT нет. И это своего рода компромисс. Потеряв авторегрессию, BERT приобрел способность включать контекст по обе стороны слова для получения лучших результатов. XLNet вернул себе авторегрессию, найдя при этом альтернативный способ инкорпорировать контекст по обе стороны.

Выбранный диск имеет стиль разделов GPT — конвертируем в MBR

Важно! На GPT можно установить только 64-битную систему, если хотите установить 32-бита, то в любом случае придется делать конвертирование в MBR

1. Меняем GPT на MBR прямо при установке

Самый простой способ — это удалить разделы диска и продолжить установку. Но, в этом случае все данные/файлы, который на нем есть — будут удалены

Поэтому, если там есть что-то важно — сделайте вначале резервные копии, к примеру, просто перекачайте необходимые файлы на флешку или второй винчестер/SSD

1. В окне выбора раздела для установки ОС — выберите раздел, на который ставите систему, нажмите на ссылку настройки диска и далее на кнопку удаления. И так, с каждым разделом, пока не останется только надпись — Незанятое место/пространство на диске.

Важно! Удаляйте разделы только с того накопителя, на который устанавливаете систему. Обычно это — «Диск 0»

2. Выберите это «Незанятое пространство» и можете сразу начать установку системы, нажав на кнопку «Далее» или вначале создайте новый том и отформатируйте его.

Интересно! Также разделы можно удалить и из самой Windows с помощью встроенной утилиты управления дисками. Но проще сделать эту сразу при установке.

2. Конвертируем диск при установке

Также можно сделать эту же процедуру другим способом — конвертировать диск через командную строку. Все это делается в этом же окне выбора раздела для установки ОС.

Важно! Помните, что при смене схемы раздела накопитель будет полностью отформатирован. Если он был разбит на несколько частей — все будут отформатированы

Поэтому скопируйте важные файлы на другой носитель.

1. Прямо в окне выбора раздела для установки Windows нажмите на клавиатуре одновременно две клавиши — SHIFT + F10, чтобы открыть командную строку.

2. Поочередно введите команды:

- diskpart — запускаем утилиту работы с дисками

- list disk — выведет список накопителей, нам нужен тот, который с GPT разделом

- select disk N — вместо N укажите номер вашего

- clean — делаем чистку накопителя

- convert mbr — конвертируем в mbr

- exit — закрываем утилиту, затем закройте саму командную строку — кликните мышкой по значку крестика

3. Далее в окне выбора раздела нажмите на ссылку «Обновить» и можете продолжать устанавливать систему.

Генератор анекдотов

Теперь университет ИТМО показал, как GPT-3 можно использовать исключительно для развлечения. Там создали сайт, где мощнейший алгоритм современности «рассказывает» пользователям анекдоты. Модель экспериментирует с классической шуткой «заходит в бар… и заказывает…», но использует примеры из ИТ-индустрии и науки. Пользователям доступно более 300 вариантов ответов, остается лишь задать параметры сюжета: «кто входит в бар», «как входит в бар» и «что заказывает».

В итоге GPT-3 генерирует шутки про кота Шредингера, ученых и «мнимый стакан молока». Не все из них выходят удачными, но смешных и абсурдных вариантов хватает (орфография текстов сохранена. — РБК Тренды).

«В бар врывается программист и заказывает порцию отменных данных. Заказывает бешенство. Заказывает прибавку к несуществующим переменным. Заказывает порцию отменных ошибок. Заказывает порцию отменных ошибок от класса динамической памяти. Заказывает порцию отменных ошибок от класса локального пространства выполнения».

«В бар скромно протискивается Илон Маск и заказывает бокал неньютоновской жидкости. Бармен ему дает бокал водки с собой. Илон пьет, наблюдает за собой и понимает, что не успеет на конференцию в Лос-Анджелесе. Он обращается к бармену и говорит: «Хороший релиз, но я не догнаю до темноты». Бармен говорит: «Исправим в следующем релизе».

«В белом плаще с кровавым подбоем, шаркающей кавалерийской походкой заходит в бар кот Шредингера и заказывает мнимый стакан молока. Бармен подает ему наполовину заполненный стакан. Взгляд кота показывает свое сочувствие бармену и его бедности. Тот подает ему второй порцию молока. Кот пьет молоко и вынужден передать вторую часть молока бармену. Бармен опять подает коту наполовину заполненный стакан».

«Неожиданно в баре материализуется стартапер и заказывает по гранту каждому в зале. Как вы себя вели бы, если в баре материализуется стартапер заказывает по гранту каждому в зале? Варианты ответов: Я убегал бы за доходом. Я пропускал бы всех. Я оставался бы на месте, потому что был бы спокоен».

«В бар врывается программист и заказывает ящерицу в стакане. Бармен наливает ему одну ложку. На что программист говорит: «Я хочу ящерицу в стакане!» … и бесконечное число программистов говорит переставая… Или еще притча про программистов… Ошибка все вернулась…и вы теперь сможете возвращать потерянное имущество… Все взломали».

«Забегает в бар ученый ИТМО и заказывает 999999999 кружек пива. Бармен отвечает: «Простите, мы не обслуживаем благородные газы с широким диапазоном объемов». Ученый ИТМО не реагирует. Забегает в бар старый Дима Билан и заказывает 5 кружек пива».

«В бар вальяжно проходит геймдизайнер и заказывает бокал неньютоновской жидкости. Неистовый поток информации перестраивает пространство в доступные для понимания объекты. Управление этим процессом не вызывает подозрения, как когда в какой-нибудь соседней стране от снотворного начинает рваться пол и выплевываться записи телефонных разговоров».

«В бар телепортируется кот Шредингера и заказывает порцию отменных данных. Бармен в изумлении: «Вот прикол, кот думает числа пить!» Наконец заходит пиф-паф, который оставляет за собой бутылку и говорит: «Давайте сейчас дадим друг другу половину этой бутылки». Бармен наливает ему вполне определенную половину бутылки. Выписывает счет».

«В белом плаще с кровавым подбоем, шаркающей кавалерийской походкой заходит в бар Илон Маск и заказывает мнимый стакан молока. Бармен жестом приглашает Илона сесть за поломанный стол. «Зачем это? — вопрошает Илон. — Я же деньги за это плачу». «Надо значит в следующем релизе поломать стол побольше», — отвечает бармен».

«Забегает в бар ученый ИТМО и заказывает -1 кружку пива. Бармен спрашивает: «Вы верите в бесконечное число?» — «Нет!» — «Тогда принесите пиво отсюда за стол!» Заходит в бар ученый ИТМО. Подходит бармен и говорит: — Налить кружку пива? — Нет, прошу вас, выпейте из этой кружки напиток так, чтобы меня не было видно».

«С такими анекдотами нейросеть вряд ли поедет в standup-тур, но точно сможет рассмешить коллег по цеху — например, Алису или Siri», — говорит заместитель руководителя отдела имиджевых мероприятий ИТМО Александр Гостев.

Особенности учреждения

В настоящий момент подготовка специалистов в «ГПТ» проводится на дневном и заочном отделении. В образовательном процессе реализованы такие направления обучения:

- Технологические особенности обработки заготовок из твердых пород древесины.

- Основы дизайна и конструирование верхней одежды.

- Методика укрупненного нормирования сборочных работ в единичном производстве.

- Решение инженерных задач при помощи инструментов прикладного программирования.

- Соблюдение правил техники безопасности при монтаже промышленного оборудования.

Помимо основной квалификации студенты могут освоить следующие профессии:

- модельер,

- оператор,

- нормировщик.

Плодотворное партнерство с техническими ВУЗами помогает студентам завершить обучение в САФУ, МГТУ и УрГГУ.

Форма обучения: Очная, Заочная

Вид обучения: Платное, Бесплатное

Стоимость обучения: 25300-32700 рублей в год

Обучение производится на базе 9 или 11 классов

Курсы: Подготовительные курсы начинают работу 1 октября 2016 г.

Дни открытых дверей: 28 января 2017 г.

Специальности:

Экзаменационные предметы:

математика, русский язык

Визуализация маскированного внутреннего внимания

Теперь, когда мы посмотрели на то, что происходит внутри этапа внутреннего внимания Трансформера, мы перейдем к маскированному внутреннему вниманию. Оно идентично внутреннему вниманию вплоть до шага №2. Предположим, модель имеет только два токена на входе и мы рассматриваем второй. В этом случае последние два токена маскируются. Таким образом модель вмешивается в процесс распределения коэффициентов, наделяя все будущие токены нулевыми весами:

Это маскирование часто применяется в качестве матрицы, называемой маской внимания (attention mask). Возьмем, например, последовательность из четырех слов («robot must obey orders»). В случае языкового моделирования эта последовательность обрабатывается за 4 шага: один для каждого слова (с допущением, что каждое слово – это один токен). Т.к. эти модели работают батчами, мы можем установить размер батча 4 для нашей упрощенной модели, которая будет обрабатывать целую последовательность (с ее 4 шагами) как один батч.

Мы подсчитываем коэффициенты в матричной форме, перемножая матрицу Запроса на матрицу Ключа. Изобразим это следующим образом, имея в виду, что вместо слова будет стоять вектор Запроса (или Ключа), соответствующий слову в ячейке:

После перемножения мы «нахлобучиваем» нашу треугольную маску внимания. В те ячейки, которые мы хотим спрятать, она ставит или маску –бесконечность (-inf) или очень большое отрицательное число (например, -1 миллиард в GPT-2):

Затем, применяя функцию софтмакс для каждой строки, получим реальные коэффициенты, которые и будем использовать для внутреннего внимания:

Эта таблица коэффициентов означает следующее:

- Когда модель обрабатывает первый пример из набора данных (строка №1), который содержит только одно слово («robot»), 100% всего внимания будет на самом слове.

- Когда модель обрабатывает второй пример из набора данных (строка №2), который содержит слова («robot must»), во время обработки слова «must» 48% всего внимания будет на «robot» и 52% будет на слове «must».

- И т.д.

Конец первой части: GPT-2, дамы и господа

Итак, мы прошлись по тому, как работает GPT-2. Если вам любопытно узнать, что именно происходит внутри слоя внутреннего внимания, то следующая бонусная часть определенно для вас. Она была создана для того, чтобы предложить некоторые визуальные средства для описания механизма внутреннего внимания и облегчить дальнейший разбор моделей трансформера (таких как TransformerXL и XLNet).

Хотелось бы отметить некоторые упрощения, к которым пришлось прибегнуть в этой статье:

«Слова» и «токены» использовались как синонимы и в этой статье взаимозаменяемы; однако на самом деле GPT-2 использует парную байтовую кодировку (Byte Pair Encoding) для создания токенов своего словаря. Это означает, что обычно токенами являются части слова.

В нашем примере модель GPT-2 работает в режиме вывода/оценки (inference/evaluation mode). Вот почему она обрабатывает только одно слово за раз. Во время обучения модель будет обучаться на более длинных последовательностях текста и обрабатывать единовременно несколько токенов. Также на этапе обучения модель может обрабатывать батчи больших размеров (512), в отличие от батчей размером 1, которые используются в режиме оценки.

Автор был несколько волен в ротации/транспозиции векторов для лучшей организации пространства и картинок

Во время применения модели необходимо быть более точным.

В Трансформерах широко применяется техника нормализации слоев, и это достаточно важно. Мы отметили некоторые примеры ее использования в Transformer в картинках, а в этой статье в основном сосредоточимся на внутреннем внимании.

В некоторых случаях было необходимо изобразить больше квадратиков для представления вектора

Эти случаи были описаны как «zoom in», например:

Часть 2: визуализация внутреннего внимания

Ранее в статье мы показывали эту картинку для иллюстрации применения внутреннего внимания в слое, обрабатывающем слово «it»:

В этой части мы рассмотрим более детально то, как это происходит. При этом мы будем пытаться понять, что происходит с каждым конкретным словом, поэтому далее будет много иллюстраций отдельных векторов. И хотя в реальности применение внутреннего внимания происходит с помощью перемножения гигантского размера матриц, мы остановимся здесь на интуиции того, что происходит на уровне одного слова.

Интерфейс для избранных

Для тренировки больших трансформерных моделей нужны огромные вычислительные мощности. Так, создатели GPT-3 обучали ее на суперкомпьютере Microsoft Azure AI. На обычном домашнем ПК процесс мог бы занять до 500 лет.

Хотя OpenAI называет себя некоммерческой организацией, она не стала выкладывать модель в открытый доступ и вместо этого планирует продавать услуги по подписке. Летом 2020 года команда анонсировала закрытое API (Application Programming Interface — программный интерфейс приложения) на базе GPT-3. В организации подчеркивают, что полученные таким образом средства позволят продолжать исследования и развивать алгоритм. Кроме того, так OpenAI надеется сохранить контроль за использованием технологии и избежать потенциальных злоупотреблений.

На этапе тестирования бесплатный доступ предоставляют отдельным исследователям и разработчикам. Для этого требуется заполнить объемную заявку и дождаться ответа. API позволяет работать в режиме генерации текста, чата, формате «вопрос-ответ», а также собирать неструктурированные данные или пересказывать сложный текст простым языком.

Установка Windows на данный диск невозможна — оставляем GPT

1. Меняем настройки BIOS

1. При загрузке компьютера нажмите на клавишу DEL, чтобы попасть в настройки БИОС. Перейдите в раздел загрузки, обычно он называется «Boot», но может и отличаться. Нам нужен параметр «Boot Mode» — его нужно установить в значение «UEFI Boot».

2. В этом же разделе проверьте включен ли параметр «Secure Boot», он должен быть активирован.

3. Далее зайдите в расширенные/дополнительные настройки — «Advanced» и посмотрите какой параметр стоит у «SATA», установите его в значение «AHCI».

Важно! В старых материнских платах, в БИОС может не быть некоторых параметров, поэтому схему раздела все равно придется менять на MBR, как мы это делали в прошлой главе. 4

После этого, нам нужна будет флешка, сделанная специально для UEFI BIOS, но, вначале попробуйте установить и с этой, может она уже сделана нормально

4. После этого, нам нужна будет флешка, сделанная специально для UEFI BIOS, но, вначале попробуйте установить и с этой, может она уже сделана нормально.

2. Делаем UEFI-флешку со схемой в GPT

Для этого скачайте Rufus, эта утилита позволяет делать такие носители. Также для GPT загрузочную флешку по умолчанию создают официальные утилиты от Майкрософта, к примеру, Windows USB/DVD Download Tool.

1. Вставьте флешку в USB порт компьютера. Откройте утилиту, укажите образ с операционной системой и выберите схему раздела в GPT.

2. Руфус сам отформатирует носитель и сделает флешку загрузочной. Просто дождитесь окончания процесса. Затем начните установку Windows заново, проблема больше не появится.

Чаще всего не получается установить Windows 7

Сложности с установкой системы на GPT-диск с большей вероятностью возникают у пользователей, которые предпочитают Windows 7.

Для установки Windows на диск со стилем разделов GPT необходимо соблюсти два условия:

- 64-битная ОС.

- Загрузка в режиме EFI.

Исхожу из того, что вы устанавливаете 64-битную версию Windows. Это означает, что сообщение об ошибке появляется по причине несоответствия второму требованию.

Не исключено, что будет достаточно поменять настройки BIOS. Зайдите в него, нажав предусмотренную для этого клавишу. Вы увидите, какую клавишу нажимать в процессе загрузки компьютера. В ноутбуках чаще всего применяется F2, в настольных моделях — Delete.

Поменяйте загрузку CSM (Compatibility Support Mode) на UEFI.

Ищите в разделах «BIOS Setup», «BIOS Features» или подобных по смыслу. В SATA определите режим AHCI, а не IDE.

Для седьмой (и еще более древних) версий Windows нужно также выключить Secure Boot.

BIOS вашей модели компьютера может выглядеть иначе. Названия пунктов меню также могут быть другими. Но смысл всегда сохраняется.

После изменения и сохранения вами новых параметров BIOS у вас появится возможность установки системы на GPT-диск. Если вы устанавливаете ОС с DVD, то сообщение об ошибке при повторной попытке установки, скорее всего, не появится.

В случае установки с USB-накопителя сообщение может отобразиться опять. В этой ситуации необходимо пересоздать установочную флешку таким образом, чтобы она поддерживала загрузку UEFI.

Если накопителем поддерживаются два метода загрузки, удалите файл «bootmgr» в корневой директории флешки. Тем самым вы предотвратите возможность загрузки в режиме BIOS. Если нужна загрузка в режиме BIOS, удалите каталог «efi». Не делайте этого в тех случаях, когда есть хоть малейшие сомнения. Можно повредить дистрибутив.

Остальные признаки, позволяющие определить структуру

Приведу еще несколько дополнительных, но не дающих 100% гарантию признаков, которые помогут узнать вид используемого на вашем компьютерном оборудовании диска. Хотя признаки довольно полезные с точки зрения дополнительной информации:

- если в BIOS использует EFI-загрузку, то в системе установлена GPT;

- один из скрытых разделов начала системы в Виндовс 10 и 8 работает с файловой системой FAT32, а в самом описании указана фраза— «Шифрованный EFI системный раздел», то перед вами — GPT;

- элементы на диске с системой, включая скрытый раздел, обладает файловой системой NTFS — MBR;

- диск, размер которого больше 2 Тб, и/или имеется более 4-х разделов – значит GPT система.

Надеюсь, моя статья помогла вам разобраться, что такое GPT диск, и вы сможете определить, на какой технологии функционирует ваш компьютер.

Автор рекомендует:

- Подключаем беспроводные наушники к компьютеру через Bluetooth

- Как проверить жесткий диск на исправность

- Рекомендуется заменить батарею на ноутбуке: что делать с этим уведомлением?

- Как подключить смартфон к телевизору через WiFi, USB, HDMI

- Bootmgr is missing – что делать Windows 7, как исправить ошибку

- Не включается монитор при запуске компьютера: причины и решения

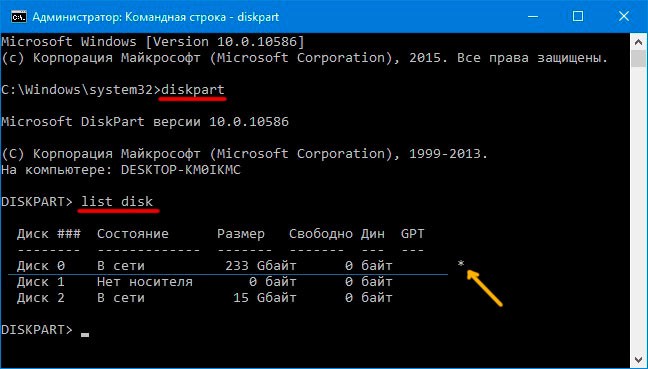

Пользуемся командной строкой

Если необходимо воспользоваться данным вариантом, можно активировать командную строчку от имени админа в операционке Виндовс или зажать комбинацию Shift + F10 (на некоторых устройствах Shift + Fn + F10 ) при установке Windows с накопителя для открытия нужной опции.

Далее в командной строчке поочередно прописываете команды:

Следует обратить внимание на последний столбик, где отмечены результаты выполнения команды list disk

Если на том месте установлена звездочка, то применяется технология GPT, а диски, не имеющие эту отметку — MBR (чаще всего стоит MBR, потому как встречаются и другие варианты, к примеру, система не может определить вид инструмента).

После просмотра всей нужной информации для закрытия окна консоли нужно ввести команду:

Доступ на русском

Пока тысячи желающих ожидали от OpenAI ответа на заявки, в открытом доступе появилась русскоязычная версия модели — ruGPT-3 Large. Ее создали разработчики из «Сбера», обучив нейросеть на датасете из 600 Гб текстов. Помимо коллекции русской литературы, в датасет включили «Википедию», новостные ресурсы и сайты с вопросами и ответами. Сюда же вошли материалы с Pikabu, научно-популярного ресурса 22century и портала banki.ru. Чтобы познакомить нейросеть с программным кодом, разработчики также добавили материалы GitHub и StackOverflow.

Для обучения ruGPT-3 Large использовался суперкомпьютер «Кристофари» и облачная Data Science-платформа ML Space от SberCloud — компании экосистемы «Сбера», предоставляющей облачные услуги.

Пообщаться с нейросетью может любой желающий на специальной странице SberCloud. Для этого нужно предложить программе небольшую «затравку» — например, незаконченное предложение или начало диалога. Результат нельзя предсказать заранее — модель создает свои ответы «на лету», и они никогда не повторяются. Создатели русскоязычной версии предупреждают, что сгенерированные тексты могут оказаться некорректными или неуместными. Цель же страницы — удовлетворить исследовательский интерес научного сообщества.

Модель и правда не всегда выдает выверенные факты. Может, к примеру, предложить вам ограничить калорийность рациона до 40-50 ккал в сутки (при рекомендованных врачами 2 тыс. ккал для взрослого человека) или употреблять в день «не больше одного салата».

Социальная экономика

Семь смертных грехов искусственного интеллекта

Но общаться с ruGPT-3 все равно интересно. Особенно — по тем вопросам, на которые у человечества пока нет однозначного ответа. Нейросеть уверена, что «лучший способ повысить продуктивность — это влюбиться». А на вопрос о том, как стать счастливым, резонно замечает: «Счастье заключается не в том, чтобы получить желаемую вещь, а в самом желании».

Помимо текста, русскоязычная модель может писать программный код. Для этого «затравку» нужно сформулировать на одном из языков программирования.

Первоначально модель обучили на 760 млн параметров, но уже в следующей версии количество параметров выросло до 1,3 млрд. Новая версия в скором времени будет также доступна на сайте SberCloud.

Нейросеть ruGPT-3 XL на 1,3 млрд параметров на данный момент занимает первое место в рейтинге нейросетей Russian SuperGLUE. С помощью метода few-shot модель без какого-либо обучения лучше всех выполнила следующие задачи: выбор лучшего решения в заданных условиях (плюс 10% точности по сравнению с предыдущей версией на 760 млн параметров), ответы на вопросы по тексту (плюс 3% точности), машинное чтение — тест на понимание общего смысла текста (плюс 32% точности).